益企解读《整机柜服务器产业研究报告》

日前,由OCTC与OCP中国社区联合举办的第13期开放计算技术沙龙成功举行,沙龙主题为“智算中心基础设施创新与实践”,汇集来自标准院所、互联网/通信/金融行业头部用户、算力系统厂商、智算基础设施上下游核心供应商等近百位技术与产业专家代表,围绕整机柜产研报告、AI互联架构、液冷整机柜等智算中心基础设施前沿话题,进行技术分享和深入研讨。

本次沙龙由OCP开放计算中国社区负责人叶毓睿主持。会上,OCTC开放计算标准工作委员会秘书长陈海发表致辞,他表示,开放计算技术沙龙搭建了一个很好的交流平台,增强了OCTC与OCP两大开放组织的联动与交流,并希望OCTC充分发挥组织牵引作用,联合产业伙伴从标准化、技术、解决方案、落地应用等方面,推动整机柜服务器、液冷散热等重点技术创新与实践,共同打造中国智算基础设施发展的良好环境。在“《整机柜服务器产业研究报告》解读及整机柜服务器技术、应用研讨”环节,来自数据中心产业上下游的多位技术专家结合报告内容解读进行了深入研讨。中国电子技术标准化研究院的高级工程师方芳对《整机柜服务器产业研究报告》的缘起、参编情况及编制过程进行了详细介绍,并对算力基础设施集约化、规模化、绿色化、智能化高质量建设发展的相关政策进行了详细解读,阐述了政策层面对于整机柜服务器产业化发展的引导和要求。

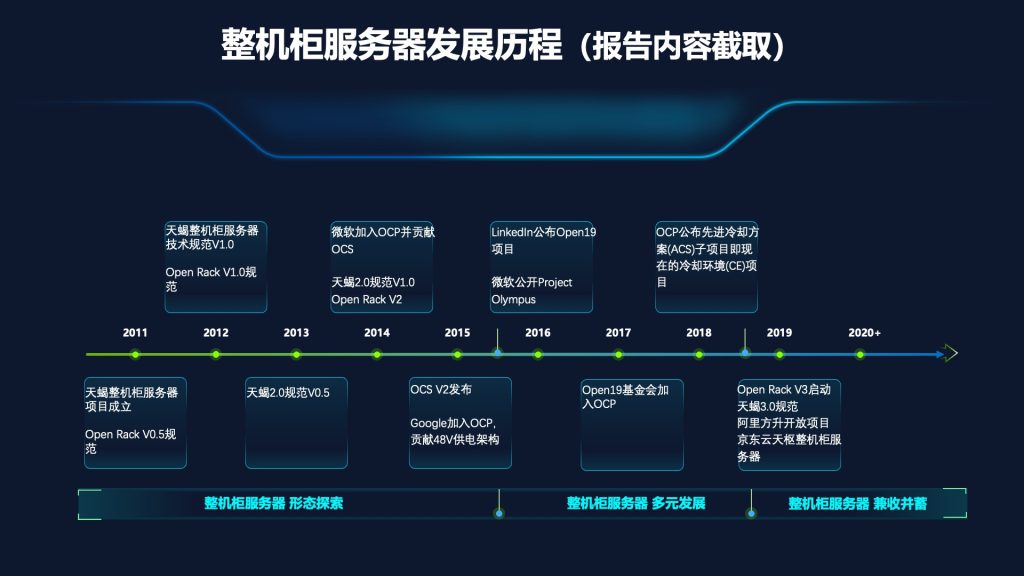

OCTC数据中心基础设施技术专题组组长张广彬对整机柜服务器的发展演进历史进行了分析,他表示,整机柜服务器有资源池化、快速交付等优点,在开放市场上的发展可以分为两个时期,先后受基础设施侧和业务应用侧的规模化驱动:

- 2010年代主要是基础设施侧的规模化,整机柜服务器打破了ICT设备和数据中心基础设施的传统分界线,池化供电和散热的实践为后续的发展奠定了基础。研究报告中将这一时期再分为形态探索、多元发展、兼收并蓄三个阶段,并对典型技术路线予以分析归纳。

- 在智算时代,业务应用侧的规模化成为推动整机柜服务器接续演进的主要动力。GPU、内存等ICT资源在整机柜层面的池化与上层业务的关系更为紧密,以GB200 NVL72为代表的超节点方案和UALink、CXL等互联技术已受到业内广泛关注。

OCTC柜计算技术专题组组长张斌则以国内领先的整机系统厂商在整机柜服务器方面的产业化实践为实例,对整机柜服务器不同阶段的业务关注、技术特征进行了介绍,并对整机柜服务器的产业趋势进行了展望:整机柜服务器已成为AI基础设施的主流形态,并将承接AI、云计算、通用计算等更加广泛的计算场景。

在三位编委成员对《整机柜服务器产业研究报告》的主要内容和核心观点进行解读后,超聚变CTO丁煜、百度AI架构师武正辉、抖音服务器架构师高晓军、曙光数创产品规划部经理白泽阳、新华三服务器产品管理部高级产品经理何伟宇、长城电源研发总监李彦、晨光博达冰芯冷却液研发架构师邓清田等产业上下游的技术专家以及用户代表如某大行技术经理等纷纷加入研讨环节,围绕整机柜服务器的业务场景需求、用户收益、技术趋势、生态现状等进行了深入、开放的讨论。针对整机柜服务器的产业生态建设问题,各位专家进行了重点探讨。AI时代给了整机柜服务器产品新的发展契机,极大推动了整机柜服务器各项技术的提升和改进,当前是一个千载难逢的时机,我们更应以开放的心态,汇聚产业力量,集合产业智慧,推进整机柜服务器的技术发展和生态完善,推出更先进的整机柜服务器解决方案。为进一步加速整机柜服务器的生态成熟和产业化进程,标准化推广、产业生态建设势在必行。未来,OCTC将继续推进整机柜服务器技术规范标准化推广及产业化认证工作,来加速智算基础设施的技术创新和发展。《整机柜服务器产业研究报告》由中国电子技术标准化研究院、中电标协开放计算标工委和新一代计算标工委牵头编写,浪潮信息、益企研究院、华为、超聚变、新华三等20余家单位共同参与编写,近期将面向产业正式发布。

来自阿里云、中国移动研究院、浪潮信息的技术专家分别对推理场景和智算中心硬件、高性能互联标准和规范,以及智算中心基础设施运维和管理等主题进行了深度分享。阿里云服务器架构师韩天分享了从 AI 硬件服务器角度对未来推理场景支持的思考。AI 服务器形态因业务变化而演进升级,如今推理成为重点。推理过程分为 Prefill(预填充) 和 Decode(解码)两个阶段,Decode 带来内存墙问题,对硬件的首要诉求是 P/D 分离,用不同的硬件架构支持,最大程度提高GPU利用率。引入CoT思考链的技术增加了机器慢思考的功能,也就需要更大的内存带宽来降低机器的思考时间。但Scale Up域的规模可能不会快速增长,Cable Tray(线缆树结构)的可靠应用是目前整机柜服务器最大的难点,未来互联系统架构将向正交、光互联发展。中国移动研究院网络与IT技术研究所技术经理李锴就“OISA(全向智感互联架构)赋能GPU互联芯生态”进行了主题分享,从智算产业对 GPU 卡间互联的高带宽、低时延需求、OISA 技术支持及进展等方面进行阐述。OISA 提出大规模 GPU 对等互联、解决 PCIe P2P 规模受限、优化报文结构、优化流控与重传等,目标是将 P2P 带宽从 50GB 提升至 800GB,时延从微秒级降至百纳秒级,希望未来可以支持超大AI集群的建设。浪潮信息服务器软件产品经理刘成平进行了“数据中心基础设施管理”主题演讲。OCTC 于 2024 年发布《数据中心物理基础设施管理要求白皮书》,开放AI基础设施管理平台 InManage Driver 软件,旨在通过构筑标准化的底层驱动为服务器上层跨平台管理提供便利。AI基础设施管理平台契合了AI算力及基础设施规模化急速扩展的现实挑战需求,可实现多品牌设备统一管理,涵盖资产数字化管理、智能监控告警、AI 故障诊断定位、自动化运维等。