开放整机柜服务器简史(OCP China Day回顾之一)

8月10日,OCP China Day 2022在北京举行。来自益企研究院(E7Research)的张广彬,人称狒哥,也就是我,受OAI项目发起人Whitney Zhao和OCP中国社区负责人叶毓睿(Peter Ye)委托,负责下午开放整机柜分论坛的开场和收尾工作——原本还有整场的主持,因为我临时被隔离在家,由叶大师代劳了,在此再次感谢。

OCP基金会负责新兴市场的副总裁Steve Helvie为大会致辞

本文是开放整机柜分论坛回顾系列的第一部分,先看一下全部议程:

开放整机柜简史

张广彬,益企研究院

京东云天枢服务器的思考与实践

丁 煜,京东科技产品副总监

天蝎5.0整机柜:中国开源整机柜技术创新与突破

郑建武,百度资深系统工程师

ORv2到ORv3机架设计的演进

楊茗棠,Delta(台达)机构高级经理

圆桌讨论

主持人:张广彬(狒哥)

讨论嘉宾:

何永占,百度服务器研发经理

曾钦杵,腾讯星星海实验室研发总监

丁 煜,京东科技产品副总监

唐卫中,Meta技术工程师

张 斌,浪潮信息服务器产品线高级经理

作为回顾系列的第一部分,本文的内容是我总结的《开放整机柜(服务器)简史》,分享和答疑加起来接近1小时,所以文字内容有较多删节,要了解全部内容请关注”E企研究院“观看演讲视频。

整机柜(服务器)的历史可以追溯到上个世纪,譬如Google在1999年“土法上马”的“软木板服务器”(corkboard server),可以说是互联网行业最早的整机柜服务器。我们的主题聚焦在“开放”,就要从2011年的Open Rack和天蝎整机柜讲起——十多年的发展不那么难梳理,我也有机会持续追踪,积累了不少一手材料。

不同于老婆饼、夫妻肺片,整机柜服务器是真的既有服务器、又有机柜,而这个机柜呢,在数据中心里通常是基础设施与IT两个团队的分界线:机柜往外归(数据中心)基础设施的团队管,机柜里面的服务器、存储等IT设备归IT的团队管。整机柜服务器把机柜和服务器作为一个整体来考虑,因为在规模等因素驱动下相对更具备打破次元壁的条件,所以它在互联网和云计算的公司里得到较为广泛的应用。

“把机柜和服务器作为一个整体来考虑”,这个“整体性”也有程度之分。改动最小的是机柜、服务器仍保持各自的完整,但是在工厂预安装、配置好,整体交付,省去在数据中心现场上架的繁琐过程,可以极大地提高交付效率。

更进一步是把机柜和服务器作为一个整体来设计,最常见的是通过池化资源提高效率。可以把服务器的一部分功能转移给机柜,譬如把供电单元(PSU,即俗称的“电源”)、风扇集中到机柜上,这时整机柜服务器就不仅仅是一种交付方式了,而是一种产品形态。

从“互不干涉”的单纯交付方式,到“你中有我”的高度集成产品,我按照通用性和集成度(或许用“耦合度”来表示更好)这两个不能算对立的角度草绘了一条开放整机柜服务器的“光谱”,旨在帮助大家理解开放整机柜服务器的发展和演变逻辑。

开放整机柜服务器“光谱”

Open Rack规范的提出,和天蝎项目(Project Scorpio)的成立,都在2011年,基本上从2012年开始推出产品,很快就进行了迭代,即天蝎2.0和Open Rack v2(ORv2),到2014年微软也加入了OCP,带来开放云服务器(Open Cloud Server),简称OCS,也很快公开了第二版,所以2012~2014年可以认为是开放整机柜发展的第一个阶段。

2016年,LinkedIn推出Open19,同年LinkedIn被微软收购,但保持相对独立运作;这一年的晚些时候微软发布了Project Olympus,用来替代OCS,所以这一行都是微软系。LinkedIn并入微软似乎没有影响Open19的走向,先是也加入了OCP,去年还贡献给了Linux基金会。这算是第二个阶段。

现在处于第三阶段。Open Rack v3一直都在发展完善中,天蝎发展了3.0、4.0,一会儿还要介绍5.0,还有2019年京东云也介绍了他们的整机柜服务器JDCloud Rack。纵轴主要以用户来划分,最下面是微软,上面一行是Open Rack,主要的用户是Facebook(Meta),再上面的天蝎BAT发起的,百度一直在推动,最上面是京东,当然这个上下也没有高低之分,部分参照了时间顺序。

横轴靠左代表通用性更好,靠右代表集成度(耦合度)更高。以最右边的天蝎1.0为例:一方面,天蝎1.0把供电单元和风扇都整合到了机柜上,与(服务器)节点高度耦合;另一方面,虽然机柜还是(看起来通用的)19英寸,但是天蝎1.0推出的比较仓促,很多细节没有统一,不同供应商的产品之间通用性不佳。

天蝎2.0和Open Rack都把机柜的内宽拓展到21英寸,但是Open Rack只集成了供电单元,没有集成风扇。

微软系的三个都相对靠左,首先因为全都是19英寸。OCS和天蝎1.0一样集成了供电、散热和管理,但它是一个12U的Chassis(子机箱),类似于刀片服务器的设计,整体还能放到标准的19英寸机柜上,所以通用性要好一些。Open19看名字就很直白,只整合了供电和交换机的线缆。从OCS切换到Project Olympus的一个逻辑是,微软作为全球第二大的云计算公司,要考虑全球部署,标准的19英寸机柜具有更好的适用性,Project Olympus主要对供电的部分做了一些改进,更便于维护。

Open Rack v3(ORv3)和天蝎3.0、4.0都加入了对19英寸标准RU的服务器节点的支持,就是所谓的标准机,所以通用性好多了,而且天蝎3.0、4.0因为服务器条件的变化,在机柜上集成风扇也不是一个必选项。京东云的整机柜是19英寸,但是它也和天蝎3.0、4.0一样可以选集成供电或不集成供电,所以这两者的相对位置我认为还有待商榷。

整机柜服务器的供配电

池化的一大好处是提高利用率。原来每个服务器有两个电源,1+1配置,冗余度50%;整合到一起以后冗余度大大降低,可以N+R,譬如9+1,而且用的电源数量减少,就可以用更大功率的电源,这样的电源通常效率也更高,还可以省电,节能降碳。不管从减少电源的采购费用(CapEx),还是从提高用电效率(OpEx)的角度,理论上都是可以节省的。

从运维的角度,供电单元集中在机柜的正面,背面只有铜排(busbar),可以做前维护。微软的Project Olympus做了个折中:PSU仍然在各个服务器上,但是对PDU做了一些改变,还是从前面拔掉节点就可以断电了。

整机柜供电池化的实践主要看一下Open Rack和天蝎。Open Rack v1分三个供电区,每个供电区有自己的供电框,铜排之间不相连,每一个供电区又有三条独立的铜排,这主要与Facebook当时使用的(2U3)计算节点有关。ORv2开始只保留中间的一条铜排,而天蝎2.0开始铜排在机柜(正面视角)的后方靠左边,Open Rack 1.0的三条铜排也有一条靠左。据我所知,双方曾经探讨过,机柜内宽都是21英寸,干脆也把铜排的位置统一一下,但最后没能达成一致。既然如此,干脆Open Rack还是保留中间,天蝎在左边。所以两边的机柜不能完全通用,节点可能主板是能通用的,但配电部分因为与铜排的位置相关,也不能完全兼容。

另外两点分别是铜排电压从12V提高到48V,以及锂离子电池备电单元(BBU或BBS),具体可以看上面的演讲视频(包括最后的答疑环节),此处不展开。

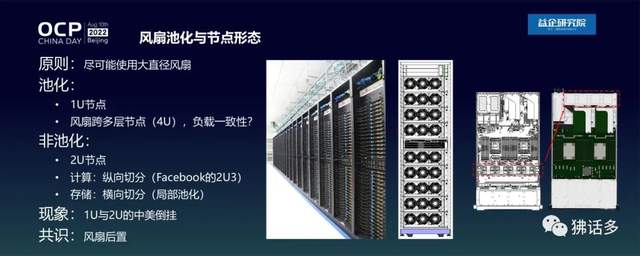

风扇池化与节点形态

散热——具体说是风扇——的池化,有类似的逻辑。取消服务器节点内部的风扇,集中到机柜后方形成风扇墙,可以采用较大尺寸的风扇,一方面减少风扇的数量,另一方面大直径风扇可以用较低的转速来提供与小尺寸风扇同等的风量,能耗和效率都会更好。譬如1U服务器必须用40毫米的小风扇,摆一排,数量很多,效率不好。天蝎整机柜采用横截面尺寸140×140的风扇组成风扇墙,就不受这个限制,大量采用1U节点。Open Rack虽然没有整合风扇,但也想用尽可能大一点的风扇,所以早期的节点都是2U,其中计算是2U3节点,存储(JBDO)节点内部是两个1U的托盘,共享2U机箱的风扇,也是为了让风扇直径尽可能大一些。

这样我们就看到一个有趣的“倒挂”现象。益企研究院组织“数字中国万里行”考察的时候,可以看到国内的数据中心,哪怕是互联网的数据中心,只要不是整机柜,或者不是超算中心,机架上大部分都是2U服务器。在国内2U服务器的占比非常高,IDC的数据也表明,国内市场2U机架服务器和1U机架服务器的出货量比例大约是4:1,而在美国2U和1U服务器的出货量大约是一半一半。就通用机架服务器而言,2U在中国占压倒优势。

但是那些年的整机柜服务器正相反,国内的天蝎整机柜以1U节点为主,而美国的Open Rack是2U的节点为主,很有意思。不管哪个流派,达成的共识是把风扇挪到服务器或机柜的最后方,即风扇后维护,算是一个成果。

机柜内宽和单位高度

机柜的内宽从19英寸拓展到21英寸,横向布局下,计算节点的数量可以增加50%,硬盘数量也可以增加25%,代价是“馅”更大显得“皮”更薄,节点的中部会有较严重的下垂。如果高度单位还是原来的标准(Rack)RU,上下节点的间隙可能不够,所以Open Rack引入了Open U(OU),把每U高度增加到48毫米;天蝎也弄了个Scorpio U,简称SU,高度46.5毫米,也比标准的RU增加了一些。可能有人会问,这个OU和SU就差1.5毫米,比SU和RU之间的距离还小,为什么OU和SU不统一呢?反正出于各种考虑最后就是没统一,退而求其次的结果是,新一代的机柜都可以兼容RU,以前甚至还不兼容,所以这也是一个进步。

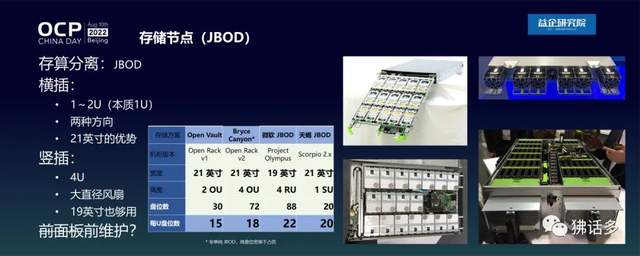

存储节点与GPU节点

随着时间的推移,2U以上的节点开始增多,主要是存储节点和GPU节点。如前所述,Open Rack的JBOD节点(代号Open Vault)其实是2U里面的2个1U,天蝎的JBOD(Just a Bunch Of Disks)和冷存储节点也都是1U,总之都是把3.5英寸硬盘平铺在托盘(tray)上,只是铺法有所区别:Open Vault是纵向铺,横向一排可以放5个,1U最多15个硬盘;天蝎JBOD和冷存储节点是横向铺,一排可以放3个,1U最多20个硬盘。

2U通用服务器把硬盘布置在前面板上,优点是便于维护,缺点是只能放12个(3.5寸),存储密度那是不能比。

真要追求存储密度,竖插是更好的方案,这样机箱的高度就以4U为宜。譬如微软Project Olympus的JBOD就是4U,可以放88个盘,即22盘/U,这还是19英寸的机柜,并没有吃21英寸的红利,密度反而更高。ORv2的存储节点Bryce Canyon就是4U规格,附带的好处是可以用(比2U)更大直径的风扇。

所以从存储的角度,只要改变了思路,其实19英寸也是够用的,不一定非要21英寸。

另一种就是GPU节点(如JBOG),譬如3U或4U,上午OCP基金会负责新兴市场的副总裁Steve Helvie在开场致辞中提到了OAI和OAM,OAI(Open Accelerator Infrastructure,开放加速器基础设施)是OCP服务器项目的子项目,OAI-OAM属于其中的开放加速器模块(OCP Accelerator Module),标准化GPU、FPGA等设备的接口和散热器外形规格。英特尔支持OAM最为积极的,从原来的Nervana到后来收购的Habana Labs,包括自己推出的数据中心GPU(代号Ponte Vecchio),都支持OAM。最近一个比较大的成果上午也提到了,就是英伟达也支持了OAI、OAM这个(子)项目,并且贡献了最新的HGX-H100 GPU基板规范,等于把HGX的精华贡献给了OCP,这是一个非常值得庆祝的事情。当然其中少不了上午Steve提到的Whitney Zhao他们的工作,我记得是在2018年年底,当时Whitney Zhao在Facebook(Meta),微软的Siamak Tavallaei, 还有百度的丁瑞全,在知道了大家有相似想法后开始合作,一起促成了OAI(包括OAM)这个(子)项目。这个合作很成功,充分证明了在项目开始的早期,大家迅速达成一致,对避免项目走向不同的分支是非常重要的。

OAI项目的发展也很快,现在OAM和UBB(Universal Baseboard,通用基板)都已经到了1.5版,今年年底之前会达到2.0版。最重要的还是OAM,随着半导体制程进步速度放缓,GPU等加速器的功耗越来越大,从一开始的450瓦(W)风冷就可以cover,到700瓦(风液)混合,甚至到1000瓦,这是很恐怖的。

整机柜与数据中心

这就要说到整机柜和数据中心之间的关系,部署整机柜一个很大的问题就是数据中心的供电限制。左图是2018年首届“数字中国万里行”参观的一个机房,单机柜7.2千瓦,放到现在国内数据中心里也是不低的水平,但是上面只放了4台2U的服务器,因为每台服务器都有2个CPU和4个GPU,功率高达2千瓦,所以也只能放4台。如果连半个机柜都放不满,叫什么整机柜(服务器)?新一代CPU的功耗现在都奔着三五百瓦去了,再想把一个机柜基本放满,没有二三十千瓦是不行的,试问国内有多少数据中心能够达到这个水平?这是机柜供电的限制。

另一个是散热能力的限制,如果达到二三十千瓦,不管从风冷的散热能力还是从PUE的角度来说,功耗都太高了,所以行业在转向液冷。如果还是风冷服务器,这些年大家为了提高数据中心效率,降低PUE,很多数据中心都已经提高了送风温度。前几年前我们看数据中心还是封闭冷通道居多,整个机房作为热通道,冷通道地板下送风,送风温度不超过20℃,整个机房(热通道)二十七八度,人在里面还是比较舒适的;近些年越来越多的数据中心为了延长使用自然冷源的时间,把送风温度提高到25℃上下,热通道的温度可以达到35℃以上,不利于人员长时间驻留。所以,新建的数据中心大多改成了封闭热通道,即整个机房是冷通道——于服务器而言,更有利于前I/O或者说是(IT侧)前维护的设计。

从液冷的角度,机柜要负责把机房提供的冷却液分配给服务器。风冷机柜就找风冷机房,液冷机柜就要数据中心提供相应设施,这些都是要匹配的。还有就是承重,液冷机柜和存储型机柜都要考虑,相应的机房地板承重能力、通道设计、电梯载重都要匹配。综合各方面来看,整机柜对数据中心的要求是更高的,OCP很早就在做相关工作,有OCP Ready这么一个项目,有一定的参考价值。

最后简单总结一下:

虽然在一些细节上没有统一,整机柜服务器和其他超大规模用户定制的服务器还是形成了与原来通用的机架式服务器很不同的形态,譬如把风扇放到后面,(集中供电的话)铜排也在后面,服务器后面基本就留给基础设施了。包括转向液冷之后,分水管、服务器上的接头也都会放在后面,还有液冷后门。液冷的前门和后门两种方案都有,不过看起来天蝎和Open Rack都更多倾向于后门,因为液冷的分水管就在后面,可以就近用同一套管路。

所以后面留给服务器或者数据中心基础设施侧的运维,前面留给IT侧的运维,是与通用服务器很不同的地方。

在机柜的结构上,一开始21英寸内宽的机柜不可避免的削弱了结构,放得还比普遍机柜更满,也等于“薄皮大馅”。通过十年的摸索,现在不管是加横向支撑还是其他手段,21英寸机柜的强度基本不是问题。

21英寸的优势当然是空间,包括内部空间,和前面板的空间。如果把后面都留给了基础设施侧,网线什么的都放在前面(前出线),OCP3.0的网卡也要放在前面,可能还有少量SSD,比如EDSFF的SSD,这个空间还是比较紧张的,那么宽了几英寸之后,确实有利于布置这些扩展设备。

另一个共识是兼容19英寸和RU(标准机),最初天蝎和Open Rack不太考虑这些,主要满足自身(大客户的定制)需求就可以。现在ORv3为OU和RU预留不同的定位孔,由机柜原生解决比用户通过其他附件去解决要好很多。

回顾开放整机柜服务器这十年的发展史,大家一开始都是图生存,先解决当下的问题,所以更强调局部的效率。所以做了很多紧耦合的事情,较少考虑兼容。后来意识到从整体来看行业效率不高,所以现在大家慢慢的又向松耦合回归,发展自己的标准,也尽可能的支持行业通用标准,给用户更多的选择权,而不是把这个产品固化下来追求局部效率最优。

用我2019年的话说,这是一个“先把厚书读薄,再把薄书读厚”的过程。

我认为,整机柜服务器在作为一种交付方式,和作为一种产品形态之间,正在找到一个比较好的平衡。

接下来的第二部分,我们将回顾京东、百度和台达专家的演讲内容,敬请期待!